✳️ 단순선형회귀 실습

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

from sklearn.linear_model import LinearRegression

from sklearn.model_selection import train_test_split

from sklearn.metrics import mean_squared_error, r2_score

# 예시 데이터 생성

np.random.seed(0)

X = 2 * np.random.rand(100, 1)

y = 4 + 3 * X + np.random.randn(100, 1)

# 데이터 분할

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 단순선형회귀 모델 생성 및 훈련

model = LinearRegression()

model.fit(X_train, y_train)

# 예측

y_pred = model.predict(X_test)

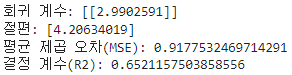

# 회귀 계수 및 절편 출력

print("회귀 계수:", model.coef_)

print("절편:", model.intercept_)

# 모델 평가

mse = mean_squared_error(y_test, y_pred)

r2 = r2_score(y_test, y_pred)

print("평균 제곱 오차(MSE):", mse)

print("결정 계수(R2):", r2)

# 시각화

plt.scatter(X, y, color='green')

plt.plot(X_test, y_pred, color='blue', linewidth=2)

plt.title('linear regeression')

plt.xlabel('X : cost')

plt.ylabel('Y : sales')

plt.show()

✳️ 다중선형회귀 실습

# 예시 데이터 생성

data = {'TV': np.random.rand(100) * 100,

'Radio': np.random.rand(100) * 50,

'Newspaper': np.random.rand(100) * 30,

'Sales': np.random.rand(100) * 100}

df = pd.DataFrame(data)

# 독립 변수(X)와 종속 변수(Y) 설정

X = df[['TV', 'Radio', 'Newspaper']]

y = df['Sales']

# 데이터 분할

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

# 다중선형회귀 모델 생성 및 훈련

model = LinearRegression()

model.fit(X_train, y_train)

# 예측

y_pred = model.predict(X_test)

# 회귀 계수 및 절편 출력

print("회귀 계수:", model.coef_)

print("절편:", model.intercept_)

# 모델 평가

mse = mean_squared_error(y_test, y_pred)

r2 = r2_score(y_test, y_pred)

print("평균 제곱 오차(MSE):", mse)

print("결정 계수(R2):", r2)

✳️ 범주형 변수 실습

# 예시 데이터 생성

data = {'Gender': ['Male', 'Female', 'Female', 'Male', 'Male'],

'Experience': [5, 7, 10, 3, 8],

'Salary': [50, 60, 65, 40, 55]}

df = pd.DataFrame(data)

# 범주형 변수 더미 변수로 변환

df = pd.get_dummies(df, drop_first=True)

# 독립 변수(X)와 종속 변수(Y) 설정

X = df[['Experience', 'Gender_Male']]

y = df['Salary']

# 단순선형회귀 모델 생성 및 훈련

model = LinearRegression()

model.fit(X, y)

# 예측

y_pred = model.predict(X)

# 회귀 계수 및 절편 출력

print("회귀 계수:", model.coef_)

print("절편:", model.intercept_)

# 모델 평가

mse = mean_squared_error(y, y_pred)

r2 = r2_score(y, y_pred)

print("평균 제곱 오차(MSE):", mse)

print("결정 계수(R2):", r2)

☑️ drop_first=True

- 범주형 변수 개수 중 1개를 빼는 것

- 어차피 마지막 1개 변수는 있으나 마나한 존재이기 때문

- 그리고 다중공선성 문제를 어느정도 해결해주기도 함

남자인 성별을 골라냈으니 false인 것들은 그냥 여자로 생각할 수 있고,

만일 5개의 범주형 데이터를 원핫인코딩을 통해 처리를 한다 해도,

4개를 인코딩하면 남은 한 개의 변수는 4개 변수에 모두 해당 되지 않는 것으로 인식할 수 있음

✳️ 다항회귀 (dgree=2) 실습

from sklearn.preprocessing import PolynomialFeatures

# 예시 데이터 생성

np.random.seed(0)

X = 2 - 3 * np.random.normal(0, 1, 100)

y = X - 2 * (X ** 2) + np.random.normal(-3, 3, 100)

X = X[:, np.newaxis]

# 다항 회귀 (2차)

polynomial_features = PolynomialFeatures(degree=2)

X_poly = polynomial_features.fit_transform(X)

model = LinearRegression()

model.fit(X_poly, y)

y_poly_pred = model.predict(X_poly)

# 모델 평가

mse = mean_squared_error(y, y_poly_pred)

r2 = r2_score(y, y_poly_pred)

print("평균 제곱 오차(MSE):", mse)

print("결정 계수(R2):", r2)

# 시각화

plt.scatter(X, y, s=10, color='g')

# 정렬된 X 값에 따른 y 값 예측

sorted_zip = sorted(zip(X, y_poly_pred))

X, y_poly_pred = zip(*sorted_zip)

plt.plot(X, y_poly_pred, color='b')

plt.title('polynomial regerssion')

plt.xlabel('area')

plt.ylabel('price')

plt.show()

'📒 Today I Learn > 📈 Statistics' 카테고리의 다른 글

| [통계학 기초] 상관 관계 및 실습 (0) | 2024.08.08 |

|---|---|

| [통계학 기초] 회귀(Regression) (0) | 2024.08.07 |

| [통계학 기초] 유의성 검정 실습 (0) | 2024.08.06 |

| [통계학 기초] 유의성 검정 (0) | 2024.08.06 |

| [통계학 기초] 데이터의 분포 실습 (0) | 2024.08.05 |